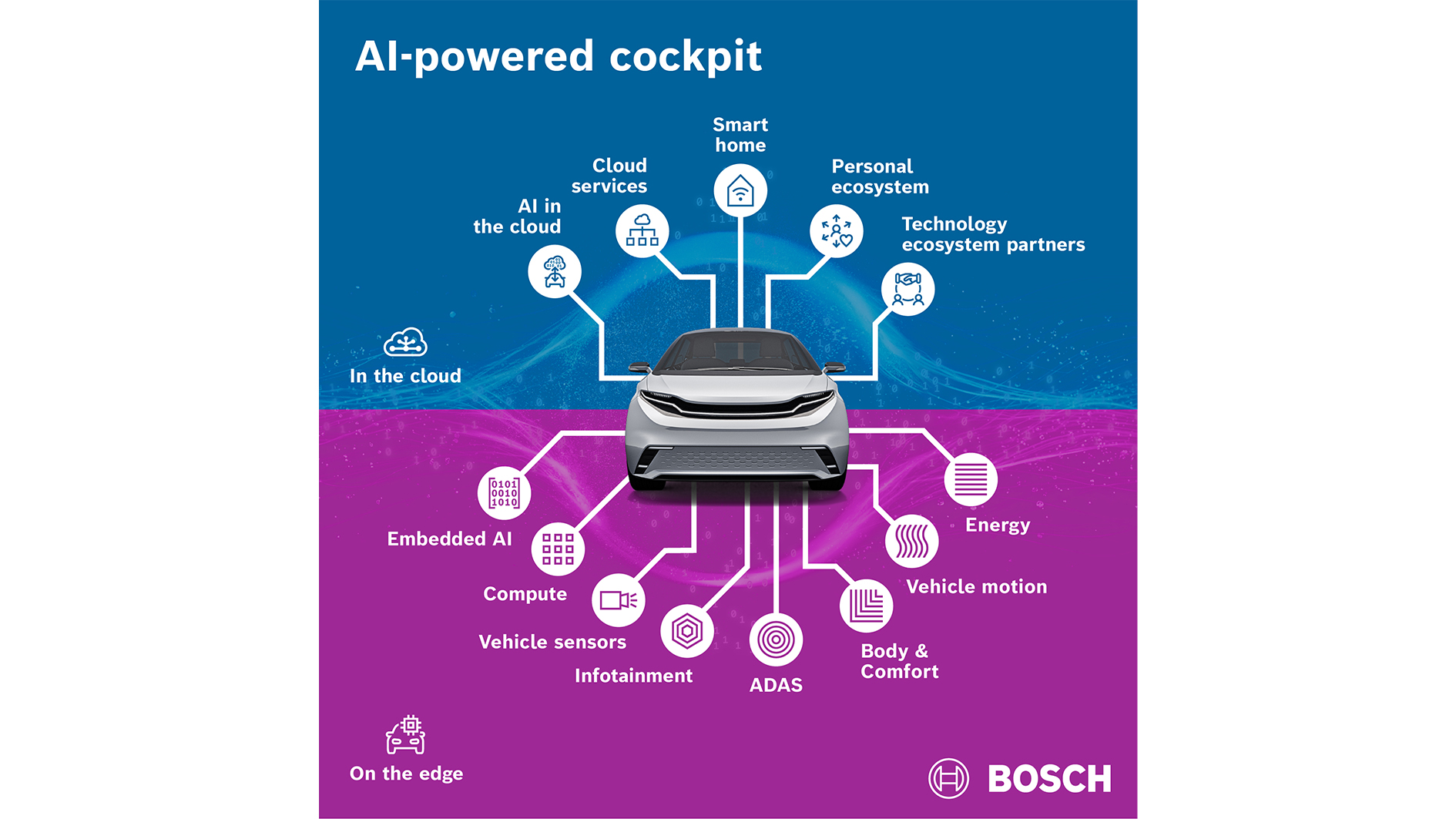

Hablamos de un bloque de hardware y software concebido por Bosch y desarrollado junto a Microsoft y NVIDIA que convive con la arquitectura actual del coche y habilita capacidades de IA en el cuadro y en el resto del cockpit. La combinación de computación acelerada y servicios en la nube permite ejecutar modelos conversacionales y visuales sobre vehículos ya en uso, sin sustituir pantallas ni unidades principales.

Qué es y cómo funciona

Bosch la describe como una “AI extension platform”: un bloque de hardware y software que convive con la arquitectura actual del coche y habilita nuevas capacidades de IA en el cuadro y el resto del cockpit. La clave es que no exige rediseñar la instrumentación ni la unidad principal, ya que directamente se acopla a los sistemas existentes y actúa como acelerador de tareas de IA, desde la voz natural hasta la percepción multimodal. Es, en esencia, una vía rápida para “actualizar” el interior sin pasar por un ciclo completo de pieza nueva y validación de proveedores.

La colaboración con Microsoft aporta la capa de nube y herramientas de desarrollo, mientras que NVIDIA suministra la computación acelerada para ejecutar modelos en el vehículo.

Una HMI más conversacional y visual

La plataforma incorpora modelos de lenguaje capaces de dialogar “como con una persona”, integrando órdenes en lenguaje natural con el estado del vehículo y la ruta. Un ejemplo típico: “tengo frío” se traduce en ajustar clima y asientos con un solo enunciado, o “llegamos con poca batería” activa sugerencias de navegación y modos de ahorro. Más allá de la voz, los análisis del sector señalan el uso de modelos de lenguaje visual (VLM) para interpretar lo que sucede dentro y fuera del coche, abriendo la puerta a interfaces que reaccionan al contexto (mirada del conductor, ocupación, señalización) sin sobrecargar la pantalla con menús.

Para el diseño, esto implica pasar de la “hiperpantalla” al contenido oportuno, ayudando así que las pantallas tengan menos capas en el menú y sea más fácil y seguro el placer de conducir. La HMI deja de ser una parrilla de iconos para convertirse en un asistente que prioriza tareas según el momento y la carga cognitiva del conductor.

Por qué importa para los fabricantes

El mayor gancho es el retrofit. Si un OEM puede añadir IA avanzada a plataformas ya en mercado sin tocar plásticos, displays o cableado principal, reduce tiempos de proyecto, evita tooling caro y acelera el time-to-market de nuevas funciones. A escala de negocio, encaja con la ambición de Bosch de crecer en software y servicios para movilidad en la próxima década, con un portfolio que va de sensores y cómputo a soluciones OTA.

Otro vector es la compatibilidad con ecosistemas existentes. Según Microsoft, la gracia de esta extensión es que “aprovecha la infraestructura de hardware del coche tal como es”, habilitando IA en el borde y sincronización con la nube para datos, entrenamiento y despliegues. Para los equipos de diseño, esto permite iterar HMI con ciclos más cortos, probar variantes de interfaz en mercados o acabados, sin encadenar cada cambio a una revisión física del cockpit.

Retos de diseño y seguridad (lo que aún falta por saber)

Una HMI más autónoma y predictiva obliga a cuidar consistencia visual, jerarquía y modos de degradación: si la IA falla o pierde conectividad, debe haber una redundancia, es decir, botones u otro tipo de controles claros, accesibles y sencillos que puedan sustituir a la IA en cualquier momento. También exigirá validar latencias, privacidad de datos y seguridad funcional. De momento, Bosch muestra demos y posicionamiento estratégico, pero no ha detallado modelos concretos, socios OEM de lanzamiento ni calendarios de integración por marca.

En 2026, la batalla de la HMI ya no va de cuántas pulgadas caben en el salpicadero, sino de qué sabe hacer la interfaz con la información del vehículo, el viaje y el conductor. Y ahí, plataformas extensibles como esta pueden acelerar una nueva hornada de interiores más inteligentes con un interior más sencillo sin tantas distracciones.